| Главная » Статьи » Мои статьи |

Думаю, что почти все владельцы сайтов желают, чтобы их странички в Интернете были посещаемыми, популярными. И многие стремятся раскутить и поднять посещаемость своих сайтов. Чем это достигается? Во-первых, сайт должен быть наполненным тематическим материалом. Дело в том, что с точки зрения роботов поисковых систем, художественное (графическое) оформление сайта (так называемый «художественный образ») и его техническая оснащённость (скрипты, Flash-модули и прочее) не играют особого значения; главнейшая же роль отведена именно тематической ценности проекта — тому, что мы и называем контент. Во-вторых, сайт должен быть виден поисковыми системами. Как же этого добиться? Как попасть в "область видимости" поисковых систем? Теперь самое время поговорить об Индексации. Индексация. Индексация – это процесс добавления страниц вашего сайта в базу данных поисковой системы. Говоря простым языком, поисковая система собирает ваши страницы, чтобы потом показывать пользователям по определенным запросам. В каком порядке показывать и по каким запросам – это тема не одной статьи. Для ускорения индексации многие рекомендуют регистрировать сайт в системах социальных закладок. Это действительно оправдано, т.к. поисковые роботы (программы, которые проводят индексацию) очень часто посещают подобные сайты. Если они увидят там ссылку на ваш ресурс, то его индексация не заставит себя долго ждать. Как же работает система индексации у крупных поисковых систем? У поисковиков есть программы-роботы (поисковые боты), которые постоянно «гуляют» по ссылкам в поисках новых страниц. Если они находят новую страницу, которая удовлетворят требованиям алгоритма данного поисковика, то она включается в результаты поиска, или проходит индексацию. ТИЦ и PR Важнейшими показателями весомости (раскрученности) сайта являются ТИЦ И

PR.

ТИЦ (тематический индекс цитирования) — это параметр поисковой системы Яндекс, определяющий авторитетность сайта с учетом количества и качества ссылок на него с других сайтов. Основная задача этого параметра — обеспечить релевантность расположения ресурсов в рубриках каталога Яндекса.

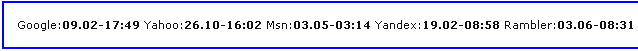

Robots.txt При индексировании наших сайтов, поисковые боты в первую очередь ищут файл Robots.txt, который должен находиться в корневом каталоге сайта. Для чего? Все просто: В этом файле прописаны команды для тех самых поисковых ботов, которые "говорят" им (ботам), какие страницы, дирректории (папки) или файлы наших сайтов можно индексировать, а какие - нет. Ведь бывает, что нужно скрыть какую-либо информацию на сайте от индексации. Подробнее о создании и применении файла Robots.txt Вы можете узнать ЗДЕСЬ. Отображение последнего захода поискового бота на текущую страницу. Ниже показан код PHP, который наглядно показывает статистику захода поисковых ботов на сайт.Это удобный скрипт, который просто подключается на всех страницах. После установки этого скрипта будут выводиться снизу страницы идентификаторы поисковых ботов и время их захода на страницу. Очень интересно наблюдать эти цифры на страницах блога, т.к. после пинга поисковые боты приходят довольно быстро и можно делать ставки какой придет раньше. Конечно на первом месте практически всегда оказывается googlebot, позже приходит Yandex:

Информация сохраняется в одном файле, статистика отображается на каждой странице сайта (точнее на тех, в которые вы подключите этот скрипт). Код PHP < ?php $logfile = "botlog.txt"; if (!file_exists ( $logfile ) ) { $log = array ( ); file_put_contents ( $logfile, serialize ( $log ) ); } else $log = unserialize ( file_get_contents ( $logfile ) ); $uri = $_SERVER [ 'REQUEST_URI' ]; $remap_agents = array ( 'googlebot' => 'Google', 'yahoo' => 'Yahoo', 'msnbot' => 'MSN', 'yandex' => 'Yandex', 'stackrambler' => 'Rambler', 'aport' => 'Aport' ); $agent=@$_SERVER [ 'HTTP_USER_AGENT' ]; if ( preg_match('/(googlebot|yahoo|msnbot|yandex|stackrambler|aport)/i', $agent, $match ) ) { $match = strtolower ( $match [ 1 ] ); $agent = $remap_agents [ $match ]; $date = date ( "d.m-H:i", time ( ) ); $log[$uri][$agent] = $date; file_put_contents ( $logfile, serialize ( $log ) ); } printf ( "Google:%s Yahoo:%s Msn:%s Yandex:%s Rambler:%s Aport:%s", @$log[$uri]['Google'], @$log[$uri]['Yahoo'], @$log[$uri]['MSN'], @$log[$uri]['Yandex'], @$log[$uri]['Rambler'], @$log[$uri]['Aport'] ); printf ( "G:%s Y:%s M:%s Y:%s R:%s A:%s", @$log[$uri]['Google'], @$log[$uri]['Yahoo'], @$log[$uri]['MSN'], @$log[$uri]['Yandex'], @$log[$uri]['Rambler'], @$log[$uri]['Aport'] ); /* function file_put_contents ( $n, $d ) { $f = @fopen ( $n, "w" ); if ( !$f ) return false; else { fwrite ( $f, $d ); fclose ( $f ); return true; } } */ ?> | |

| Просмотров: 1373 | Рейтинг: 5.0/1 |

| Всего комментариев: 0 | |